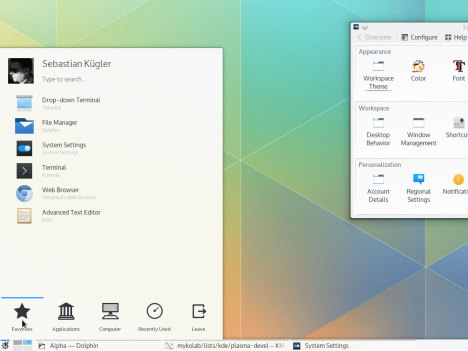

Neuer Linux-Desktop: Plasma 5 (Software)

Plasma 5 ist der neueste Linux-Desktop des KDE-Projekts.

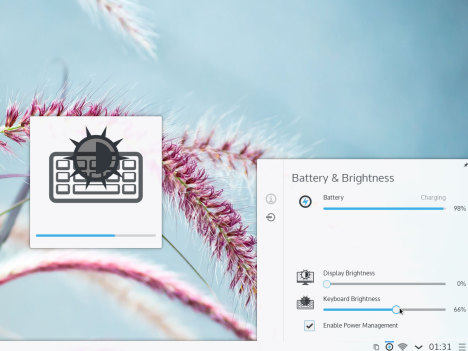

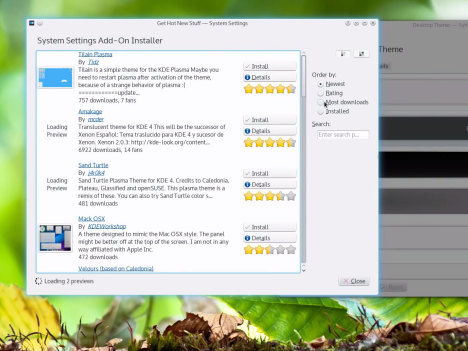

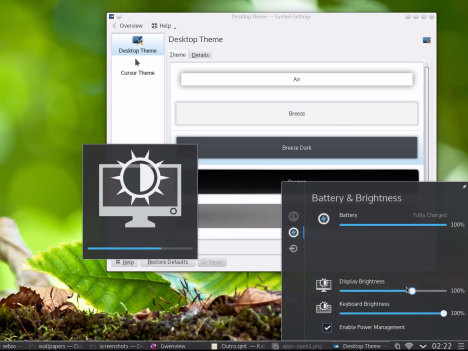

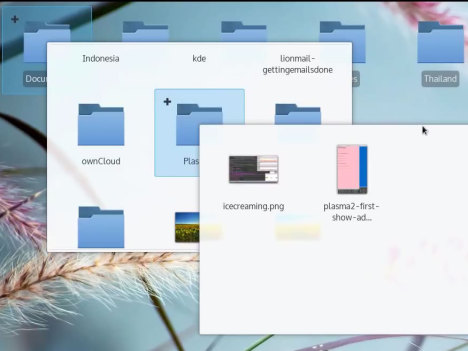

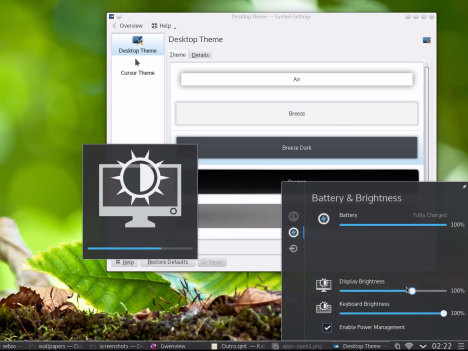

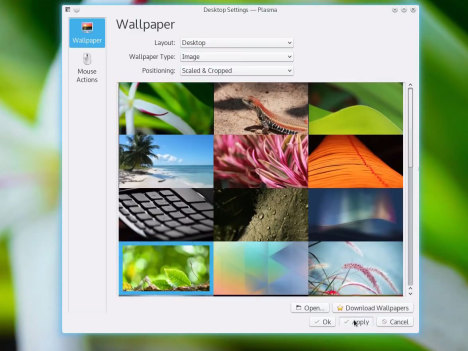

Die grafische Oberfläche hat eine neue Technik unter der Haube und setzt jetzt auf OpenGL. Vorteil: Die Grafik-Hardware kann dadurch mehr Aufgaben vom Hauptprozessor übernehmen, was zu einer flüssigeren Darstellung führt. Doch die Technik im Unterbau fällt zuerst nicht auf, denn das neue Theme Breeze ist ein absoluter Hingucker. Wer sich selbst schnell einen Eindruck von Plasma 5 verschaffen will, kann sich eine spezielle Kubuntu-Version mit vorinstalliertem Plasma-Desktop holen. Die testet man aber am besten an einem eigenen Computer, in der VirtualBox zeigen sich die neuen Plasma-Effekte nicht.

Weniger Ablenkung für Nutzer

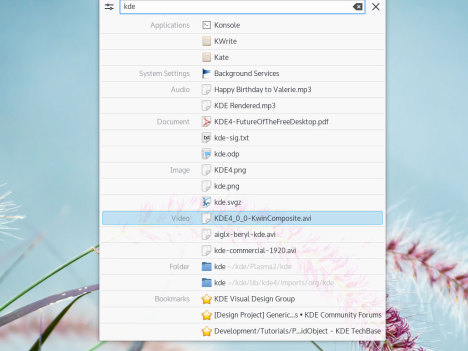

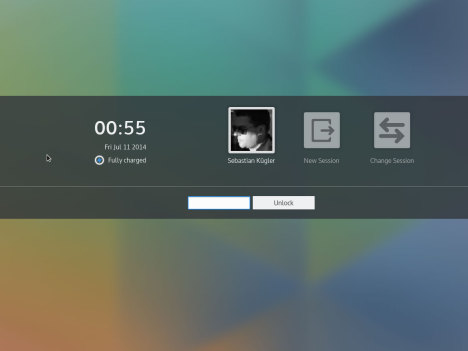

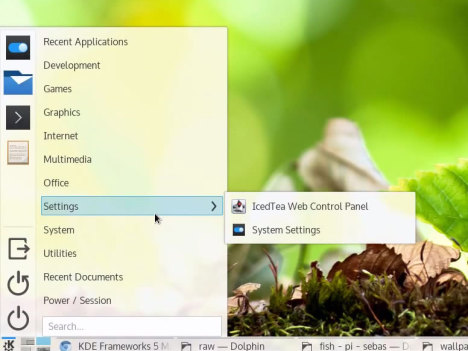

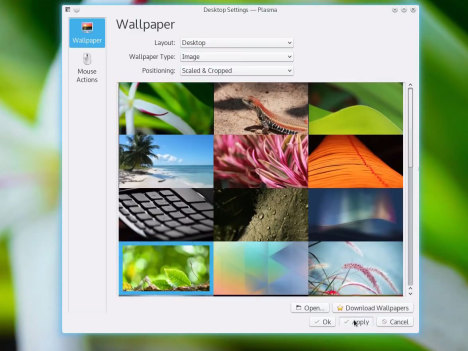

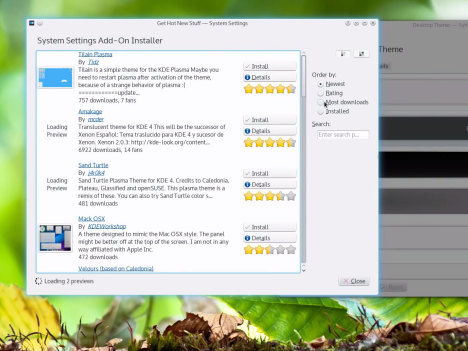

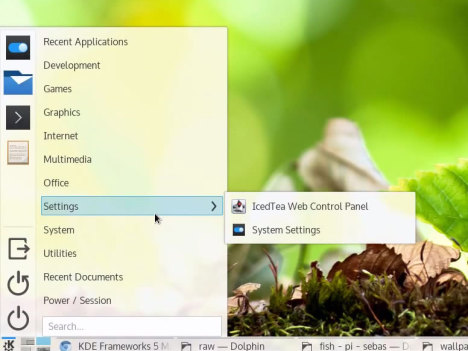

Plasma 5 verbessert die Unterstützung für hochauflösende Displays. Im Detail gibt es überarbeitete Launcher und Menüs. Die sollen mit dem neuen Design den Blick für das Wesentliche bieten. Wichtig ist auch die Überarbeitung bei Desktop-Mitteilungen. So soll es jetzt weniger Popups geben, stattdessen werden Meldungen für den Nutzer unauffällig gesammelt. Aktuell sind noch nicht alle Features des Vorgängers im neuen Kleid umgesetzt. Wer also möglichst viele Funktionen will, sollte mit dem Umstieg noch warten.

Bildserie1:

Mit Plasma 5 erneuern die KDE-Entwickler nun die Oberfläche der Desktop-Umgebung, nachdem sie mit Frameworks 5 und Qt 5 schon das Fundament gelegt hatten. Ein neuer Grafikstack verspricht dabei eine hardware-beschleunigte Anzeige der optischen Effekte.

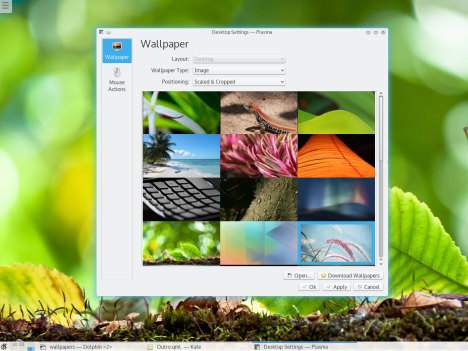

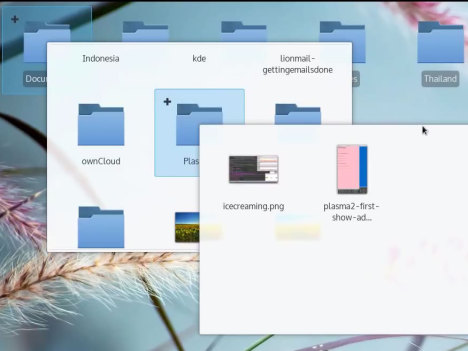

Plasma 5.0 ist ein weiterer Schritt hin zu einem runderneuerten Desktop. Nach Frameworks 5 und Qt 5 packen die Entwickler nun den Desktop an, der mit dem neuen Artwork "Breeze" eine schlichtes, funktionale Optik erhalten hat. Die Elemente erinnern an die Oberfläche von Mobilgeräten. Wer vom bisherigen Desktop umsteigt, findet sich in der Regel schnell zurecht. Die neue Plasma-Shell böte jedoch die Möglichkeit, die Oberfläche sehr weitgehend anzupassen. Das soll künftig vor allem bei anderen Geräte, wie Tablets zum Tragen kommen.

Ein Video des KDE-Teams zeigt, welche Funktionen der Anwender schon jetzt von der Oberfläche erwarten darf. Dabei finden sich bekannte und bewährte Elemente, wie das Panel am unteren Rand des Desktops, das Startmenü sowie die Widgets wieder. Durch den neuen Grafikstack auf Basis von Open-GL-(ES)-Scenegraph passen sich die sparsamen Effekte flüssig in den Ablauf der Aktionen ein. Wer die Effekte aber richtig nutzen möchte, braucht aktuelle Hardware mit den entsprechenden Treibern.

Neben Verbesserungen zum Beispiel im Bereich der Nachrichtenleiste erhielt die Umgebung mit diesem Release, an dem die Entwickler rund zwei Jahre gearbeitet haben, unter anderem die Unterstützung für Bildschirme mit hoher Pixeldichte. Das erleichtert das Lesen von Text auf diesen Displays, ohne das die Schrift skaliert werden müsste.

Wer den neuen Desktop ausprobieren möchte, kann auf ein fertiges ISO-Image Neon 5 zurückzugreifen, die das KDE-nahe Unternehmen Blue Systems bereit stellt. Allerdings ist beim Betrieb in einem Live-System immer mit Einbußen bei der Performance zu rechnen. Auf einer Wiki-Seite versuchen die Entwickler zu dokumentieren, für welche Distributionen schon fertige Pakete vorliegen. Derzeit finden sich unter den Kandidaten Arch, Kubuntu und Open Suse. Entsprechende Anleitungen zum Einspielen der Pakete finden sich dort ebenfalls.

Die Kollegen von Golem haben sich den Desktop sehr genau angeschaut und dabei einige Ungereimtheiten festgestellt, die sich auf die Tatsache zurückführen ließen, dass es zum derzeitigen Zeitpunkt noch nicht alle Applikationen im neuen Gewand gibt. Die gute Nachricht für Anwender: Anwendungen aus KDE 4 lassen sich relativ problemlos in Plasma 5.0 starten.

Bildserie2:

Mit Plasma 5 erneuern die KDE-Entwickler nun die Oberfläche der Desktop-Umgebung, nachdem sie mit Frameworks 5 und Qt 5 schon das Fundament gelegt hatten. Ein neuer Grafikstack verspricht dabei eine hardware-beschleunigte Anzeige der optischen Effekte.

Quelle: Chip, Linux-Magazin