Datenschutz durch verschiedene Betriebssysteme (Technikwelt)

Plötzlich ist das Notebook kaputt und erwacht nicht mehr zum Leben. Tage der Arbeit und wichtige Kundendaten sind einfach weg. Und das ausgerechnet vor einer wichtigen Besprechung. Hätte man doch nur ein Backup gemacht! In diesem Fall sind „nur“ die Daten eines einzelnen Notebooks verloren gegangen.

Schadprogramme, Brand oder etwa Diebstahl können zu noch weit größeren Datenverlusten führen. Wir zeigen Ihnen daher in diesem Beitrag, welche Möglichkeiten der Datensicherung Ihnen zur Verfügung stehen und was Sie in Hinblick auf die Wiederherstellung der Daten beachten sollten.

Eine wartungsfreie und zudem kostengünstige Möglichkeit zur Datensicherung stellen cloudbasierte Backup-Lösungen dar. Voraussetzung für diese Form der Datensicherung ist eine stabile Internetverbindung.

So funktioniert es: Sowohl auf Ihrem Server wie auch den einzelnen Arbeitsgeräten Ihrer Mitarbeiter wird eine Software installiert, die sämtliche Daten automatisch und verschlüsselt an das Rechenzentrum Ihres Providers sendet. Dort werden die Daten komprimiert und verschlüsselt abgelegt. Die Entschlüsselung der Daten können nur Sie selbst oder Ihr Mitarbeiter mit einem Passwort vornehmen. Wurde also beispielsweise einem Mitarbeiter der Laptop gestohlen, dann kann dieser seine gesamten Daten mit seinem Passwort über die lokal gespeicherte Software wiederherstellen.

Die Vorteile der Datensicherung in der CloudCloudbasierte Lösungen zur Datensicherung, wie etwa Backuppool Pro, bieten Ihnen viele Vorteile:

Eine Einheitslösung für die Datensicherung im Unternehmen gibt es weder für komplexe IT-Systeme noch für mittlere und kleine Netzwerke. Der benötigte Funktionsumfang Ihrer Backup-Lösung ist von der generellen IT-Infrastruktur Ihres Unternehmens und der Art der einzelnen Applikationen (Anwendungen) abhängig.

Welche Speichermedien und Software-Lösungen Ihnen für die Datensicherung zur Verfügung stehen, haben wir nachfolgend überblicksmäßig für Sie zusammengefasst.

Speichermedien für die DatensicherungGrundsätzlich hängt die Entscheidung für ein Backup-Medium von der zu sichernden Datenmenge und der geplanten Speicherdauer ab. Sämtliche Backup-Datenträger sollten an einem sicheren Ort – außerhalb der Büroräumlichkeiten – kühl und trocken aufbewahrt werden.

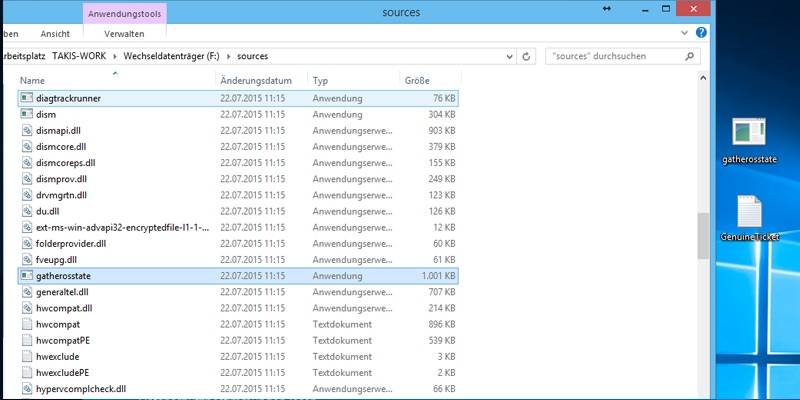

Ab einer bestimmten Datenmenge ist es sinnvoll, eine geeignete Sicherungssoftware einzusetzen, die Datensicherungen automatisch durchführt und Zusatzapplikationen bietet. Diese Möglichkeiten stehen Ihnen grundsätzlich zur Verfügung:

Viele Unternehmen investieren viel Zeit und Energie in die Datensicherung, schenken aber der Wiederherstellung der gesicherten Daten (Restore) zu wenig Aufmerksamkeit. Im Ernstfall sind dann plötzlich Festplatten defekt oder Daten können nach der Wiederherstellung nicht mehr gelesen werden. So können Sie verhindern, dass es dazu kommt:

Der Universal Serial Bus – kurz USB – hat sich als die Standardschnittstelle für PC-Hardware und zunehmend auch bei Unterhaltungselektronik etabliert. Mit dem neuen 3.1er-Standard kommen einige Verbesserungen.

Als USB 1.0 im Jahr 1996 eingeführt wurde, gab es erstmals eine Möglichkeit, zig Geräte wie Scanner, Drucker und Festplatten über eine einheitliche Schnittstelle am Desktop-PC anzuschließen, ohne erst eine damals sündhaft teure SCSI-Steckkarte in den PC einzubauen und entsprechende Endgeräte zu kaufen. Dank dem Universal Serial Bus ist das heute kaum noch nötig. USB 1.0 bot eine Datenrate von bis zu 1,5 MB pro Sekunde (Full Speed). Für Mäuse, Tastaturen, Drucker oder Scanner war das jedoch ausreichend.

Es folgten vier Jahre später USB 2.0 mit 60 MB (Hi-Speed) und im Jahr 2008 wurde der USB-3.0-Standard mit 500 MB pro Sekunde (Super Speed) eingeführt. Die USB Promoter Group hat auf der CES 2013 in Las Vegas den künftigen USB-Standard 3.1 vorgestellt: Die verbesserte Schnittstelle von Super Speed USB sieht Datenübertragungen mit bis zu 10 Gigabit pro Sekunde vor. Die tatsächlich erreichbaren Datenraten liegen aber bei allen USB-Standard deutlich darunter. So kommen beispielsweise externe USB-3.0-Festplatten kaum über 100 MB pro Sekunde.

Mit der Einführung von USB wurde das Zusammenspiel von PCs, Speichermedien und Peripheriegeräten wesentlich vereinfacht. Inzwischen haben USB-Ports längst die IT verlassen und finden sich unter anderem an DSL- und WLAN-Routern, Fernsehern, Medienplayern, Autoradios und Spielekonsolen, aber auch an Steuerungsanlagen für Strom und Heizung sowie im Auto (siehe Geräte mit USB-Anschluss ). So lassen sich eine Vielzahl von Geräten anschließen, darunter Speichersticks, externe Festplatten, Tastaturen, Mäuse, Scanner, Drucker und zahlreiche Gadgets wie kleine Ventilatoren, Staubsauger, beheizte Kaffeebecher und vieles weitere mehr (siehe USB-Gadgets ), die ihren benötigten Strom aus der USB-Verbindung beziehen.

Das Gute vorweg: Die USB-Standards 1.0 bis 3.0 sind kompatibel zueinander. USB-2.0-Geräte lassen sich an USB-3.0-Buchsen betreiben. Konkret: Eine externe Festplatte mit einem USB-2.0-Port kann an einen PC oder ein Notebook mit einer USB-3.0-Schnittstelle verbunden werden. Bei der Geschwindigkeit richtet sich USB 3.0 wie bereits USB 2.0 nach dem jeweils schwächsten Glied in der Kette. Aufgrund der zusätzlichen Kontakte nehmen USB-2.0-Buchsen jedoch keine USB-3.0-Stecker auf. Ein USB-Stick nach dem 3er-Standard passt aber auch in einer 2er-Port.

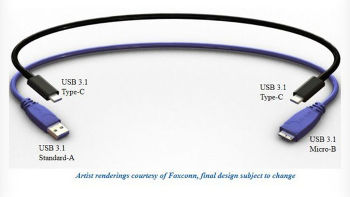

USB-Kabel: Die Kabel für die USB-Standards 1 und 2 besitzen an einem Ende den flachen Stecker Typ A, der zum PC führt. Am anderen Ende kann ein eckiger Stecker von Typ B sitzen, den Sie beispielsweise an einem Drucker oder Scanner anschließen.

Der Typ-B-Stecker für USB-3.0-Geräte ist zweigeteilt. Dann gibt es noch die kleinen Mini-B-Stecker, die beispielsweise bei externen 2,5-Zoll-Festplatten verwendet werden. Der Micro-B-Stecker ist etwas flacher, die zugehörige Buchse steckt in den meisten Fällen in Smartphones, Tablets, Kameras oder anderen kleinen Geräten. Die USB-3.0-Ausführung von Micro B ist etwas breiter und besitzt eine Kerbe im Führungsblech. USB-3.0-Stecker und Buchsen sind im Innenteil in der Regel blau gefärbt, bei USB 2.0 ist es schwarz oder weiß. Beim USB Type-C oder USB 3.1 genannt, gibt es neue Kabel, Stecker und Geräte: Der neue Stecker bei USB Type-C hat die Größe eines USB-2.0-Micro-B-Steckers.

Viel wichtiger noch: Das nervige Rumfummeln beim Anschließen von USB-Geräten wird künftig der Vergangenheit angehören. Denn bei den neuen Steckern ist es egal, wie herum man sie in den Anschluss steckt. Und auch auf beiden Seiten des Kabels befindet sich der gleiche Stecker. Apple hatte dies mit seinem Lightning-Anschluss vorgemacht, der seit dem iPad 4 und dem iPhone 5 zum Einsatz kommt.

Über die Zeit hinweg dürften die neuen Kabel auch den Einsatz von Netzteilen bei Laptops und kleineren Geräten überflüssig machen. Denn USB Type-C überträgt auch bis zu 100 Watt Strom. Abwärtskompatibel ist USB Type-C zwar, allerdings werden für bestehende USB-Anschlüsse Adapter benötigt.

Die Kabellänge: Sie ist bei USB 2.0 auf fünf Meter begrenzt. In der USB-3.0-Spezifikation sind statt der Länge elektrische Parameter festgelegt, die die Kabel erfüllen müssen. Drei Meter sind möglich, bei besonders guter Abschirmung auch mehr. Es werden jedoch auch Kabel verkauft, die den Anforderungen nicht genügen. Bei Verbindungsabbrüchen sollten Sie daher probeweise einmal ein anderes USB-Kabel verwenden.

Normalerweise kommt bei USB-Verbindungen das Polling-Verfahren zum Einsatz. Damit fragt der Host alle angeschlossenen Peripherie-Geräte regelmäßig ab, ob sie Daten zum Übertragen haben. Diese Abfrage kostet jedoch unnötig Zeit. Bei USB 3.0 können die Geräte das Polling unterbinden, indem sie von sich aus den Status NRDY („Not Ready“) melden. Hat ein Gerät später Daten zu übertragen, meldet es ERDY („Endpoint Ready“), um den Transfer zu starten. Durch die getrennten Sende und Empfangsleitungen SSTX+/- und SSRX+/- muss es nicht erst auf die Buszuteilung vom Host warten.

Geräte, die den NRDY-Status gesendet haben, können sich in einen Stromsparmodus versetzen. Denn neben der aktiven Verbindung U0 kennen die USB-3.0-Geräte drei weitere Modi: Bei U1 schaltet sich der Sende- und Empfangsschaltkreis ab. Bei U2 wird auch der Taktgeberschaltkreis unterbrochen. U3 versetzt das Gerät in den Ruhezustand (Suspend-Modus). Wenn sich alle Geräte im Stromsparmodus befinden, kann auch der Host seinen Upstream-Link herunterfahren.

Eine häufigere Quelle von Problemen ist auch die Stromversorgung über USB. Am USB-2.0-Port dürfen Geräte maximal 500 Milliampere Strom beziehen, bei USB 3.0 sind es 900 Milliampere. Der Anlaufstrom, aber auch der Strombedarf während des Betriebs kann bei einigen USB-Festplatten jedoch über 500 Milliampere liegen. Diese werden dann gar nicht erst vom Betriebssystem erkannt oder später wieder ausgehängt. In diesem Fall sollten Sie die Platte – wenn vorhanden – mit einen USB-3.0-Anschluss verbinden oder ein zusätzliches Netzteil über ein USB-Zwillingskabel (Y-Kabel) anschließen, das für wenige Euro im Handel zu haben ist.

Letzteres ist aber nach dem offiziellen USB-Standard eigentlich nicht zulässig, es funktioniert aber meistens trotzdem. Eine Verbesserung kann auch ein aktiver USB-Hub mit eigener Spannungsversorgung bieten, der außerdem den gleichzeitigen Anschluss mehrerer USB-Geräte erlaubt.

Mithilfe eines Ladeadapters kann ein Smartphone an der Steckdose aufladen werden. Alternativ stecken Sie Ihr Gerät einfach an der USB-Buchse Ihres PCs an und laden es auf. Dabei gibt es allerdings einige wesentliche Unterschiede. Wenn Sie es eilig haben, dann sollten Sie Ihr Smartphone immer an der Steckdose aufladen. Im Schnitt laden Sie Ihr Gerät über den Strom aus der Steckdose dreimal so schnell auf wie beim Laden über den USB-Port des Computers. So dauert es bei unserem Testgerät, dem Samsung Galaxy S4 Mini, 3:01 Stunden, bis ein 60-prozentiger Ladestand erreicht ist. Die gleiche Ladung erreicht das Mini über die Steckdose in 1:15 Stunden.

Langsamer Ladevorgang am USB-Port: Da ein USB-2.0-Anschluss maximal 500 mA ausliefert, dauert das Laden des angeschlossenen Smartphones entsprechend lange, weil die Kapazität der aktuellen Smartphone-Akkus sehr hoch ist. Mit USB 3.0 wurde die Stromstärke auf 900 mA erhöht, wodurch Sie das Gerät geringfügig schneller laden.

Beim Ladevorgang beachten: Die optimale Ladespannung von Ladegeräten für Lithium-Ionen-Akkus liegt bei 4,2 Volt. Die meisten Ladegeräte liegen mit ihrer Ladespannung von etwa 5 Volt noch im Toleranzbereich. Darüber hinaus geben sie in der Regel eine Stromstärke zwischen 700 und 1000 mA an die Akkus weiter. Achten Sie darauf, dass der Ladestrom der Ladegeräte in mA ungefähr das 0,6- bis 1-fache der Akkukapazität in mAh der Smartphone-Batterie aufbringt. Höhere Stromstärken können die Akku-Lebensdauer reduzieren, niedrigere Stärken können das Ladegerät überhitzen.

Microsoft und Miele zeigen auf der Hannover Messe eine Studie, mit der selbst absolute Kochmuffel akzeptable Gerichte zustande bekommen sollen. Dank des Internets der Dinge.

Auf der Hannover Messe von 13. bis 17. April zeigt der Haushaltsgeräte-Experte Miele eine Projektstudie, die auf Microsoft Azure Internet of Things (IoT)-Diensten basiert. Damit wollen Miele und Microsoft die nächste Generation von smarten Kochgeräten einleiten: Anwender können ihren Herd mit einem Assistenzsystem und Online-Rezepten so programmieren, dass Mahlzeiten perfekt gelingen (sollen).

Das Ganze soll folgendermaßen funktionieren: Nutzer haben die Möglichkeit unter den Rezepten auf der Website von Miele nachzuschlagen. Wenn der Anwender ein Gericht auswählt, sendet der Server die notwendigen Zubereitungsstufen auf das Smartphone oder Tablet des Nutzers und lädt zudem das passende Automatikprogramm über Microsoft Azure auf den Backofen. Dieser ist dann so programmiert, dass er die Mahlzeit unter Berücksichtigung von Betriebsart, Temperatur, Kochzeit, Feuchtigkeit und anderen Faktoren zubereitet. Fehlerquellen sollen so weitgehend ausgeschlossen werden, weil Rezepte wie Automatikprogramme in den Miele-Versuchsküchen auf die Geräte des Herstellers abgestimmt wurden. Zumindest verkündet das Microsoft so optimistisch.

„Dieses Assistenzsystem bezieht Temperaturverläufe, Zeiten und Besonderheiten unserer Geräte wie die Zugabe von Dampf auf bestmögliche Weise in die Zubereitungsprozesse beim Braten, Backen und Garen ein“, erklärt Dr. Eduard Sailer, Geschäftsführer Technik bei Miele. „So können Kunden das Optimum aus ihren Kochgeräten herausholen.“

Polettos Kochschule ? Mein neuer Grundkurs für EinsteigerFernseh-Köchin Cornelia Poletto bietet mit ihrer Einsteiger-App einen Grundkurs mit 90 Rezepten aus elf unterschiedlichen Kategorien. Neben ausführlichen Zutaten-Beschreibungen und detaillierten Schritt-für-Schritt-Anleitungen, finden sich hier auch Videos, die das Zubereiten von Menüs zum Kinderspiel machen sollen.

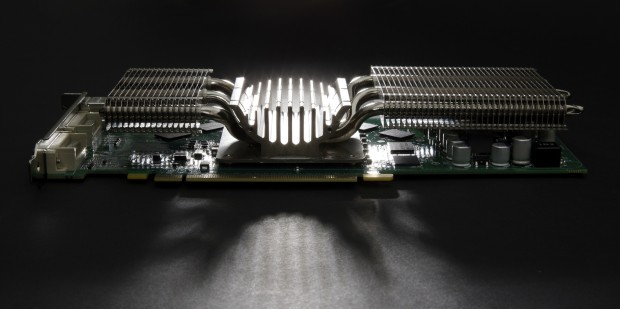

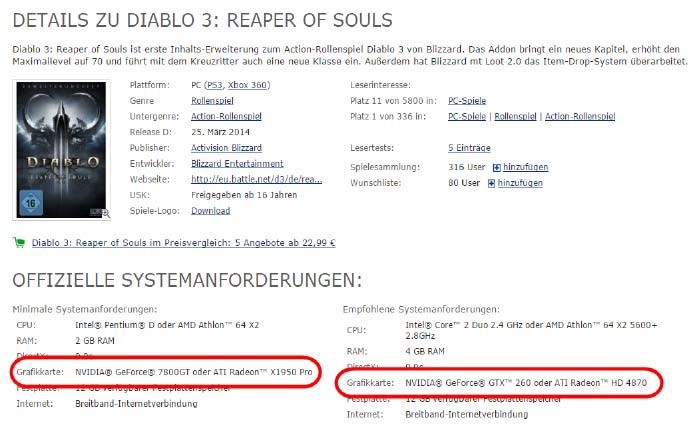

Die Grafikkarte ist ein weiterer wichtiger Leistungsfaktor. Besonders bemerkbar macht sich dies bei aktuellen Spielen oder auch beim Schnitt von HD-Filmmaterial.

Das Anforderungsspektrum an eine Grafikkarte ist sehr breit: Die Nutzer von Office und Internet können ihre Arbeit selbst an einem hochauflösenden Monitor mit einer Standardgrafikkarte für deutlich unter 100 Euro verrichten. Für ein aktuelles Spiel mit realistischer Grafik in Echtzeit sind mindestens 2 GB Hauptspeicher und ein Prozessor mit 800 MHz notwendig. Grafikkarten mit diesen Leistungswerten erzeugen dann auch problemlos eine Auflösung von 4K mit einer entsprechenden Farbtiefe. Für eine solche Grafikkarte liegen die Preise in der Regel noch unter 200 Euro.

Bevor Sie sich an die Auswahl einer Grafikkarte machen, sollten Sie zunächst einige Rahmenfaktoren betrachten, sowohl was die Leistung Ihrer CPU als auch den vorhandenen Platz in Ihrem Gehäuse betrifft.

Eine Grafikkarte sollte immer zu den restlichen Komponenten des PCs passen. Ist sie zu überdimensioniert, kann die vorhandene Leistung nicht umgesetzt werden und Sie haben zu viel Geld ausgegeben. So macht es keinen Sinn beispielsweise viel Geld in einen i7-Prozessor zu investieren und den Rechner nur mit einer 100-Euro-Grafikkarte zu bestücken. Genauso wenig liefert die Kombination aus einer Highend-Grafikkarte und einem i3 das optimale Ergebnis. Auf der Website von Passmark finden Sie eine sehr umfangreiche Übersicht von Testergebnissen – sowohl von CPUs als auch von GPUs . Dort können Sie zum Beispiel auch nach Grafikkarten mit dem besten Preis-Leistungs-Verhältnis suchen.

Es gibt zudem eine Reihe von baulichen Faktoren, die Sie bei der Auswahl Ihrer neuen Grafikkarte beachten sollten. Gerade bei kleinen Gehäusen passt nicht jede Karte in jeden Slot. Oftmals ist ein Kühler oder ein anderes Bauelement im Weg, wenn es sich um lange oder breite Karten handelt, die über mehrere Slots gehen. Messen Sie deswegen sorgfältig den zur Verfügung stehenden Platz aus und berücksichtigen Sie dies ebenfalls bei Ihrer Auswahl. Darüber hinaus sind der Stromanschluss sowie der Strombedarf einer Grafikkarte wichtige Faktoren. Aktuelle Grafikkarten sind entweder mit einem sechsoder einem achtpoligen Stromanschluss ausgestattet. Eine Highend-Karte kann schnell einmal 200 Watt und mehr benötigen. Prüfen Sie deswegen, ob Ihr Netzteil genügend Strom für alle verwendeten Komponenten zur Verfügung stellt.

Als Letztes sollten Sie außerdem noch die vorhandenen Schnittstellen auf Ihrem Mainboard überprüfen. Aktuelle Grafikkarten setzen eine PCI-Express-Schnittstelle voraus. Diese ist bereits seit Jahren gängiger Standard. Sollten Sie noch ein älteres Mainboard besitzen, steht in der Regel lediglich ein PCI-Slot zur Verfügung. In diesem Fall sollten Sie den kompletten Austausch von Mainboard, CPU und Grafikkarte in Betracht ziehen.

Zentrale Eigenschaften einer Grafikkarte sind die Leistung des Prozessors sowie die Größe und die Eigenschaften des Speichers. Bei der GPU, dem Prozessor der Grafikkarte, gibt es aktuell drei große Hersteller: Intel, AMD und Nvidia. Der mit Abstand größte Produzent ist Intel mit einem Marktanteil von über 60 Prozent. Oftmals finden Sie die Intel-GPU integriert in eine Intel-CPU.

Intel-GPUs sind eher selten auf aktuellen Grafikkarten. Diesen Bereich teilen sich die Hersteller AMD und Nvidia untereinander auf. Die beiden liefern sich immer wieder ein Kopf-an- Kopf-Rennen um die Plätze 2 und 3. Laut Angaben von John Peddie Research liegen im dritten Quartal 2014 AMD und Nvidia gleichauf.

Es gibt weder in Bezug auf die Leistung noch die Eigenschaften der Grafikkarten großartige Ausschläge in die eine oder die andere Richtung. Aus diesem Grund erhalten Sie auch bei aktuellen Spielen stets eine Mindestanforderung sowohl für eine Grafikkarte aus der AMD als auch aus der Nvidia-Welt.

Der Speicher auf den Grafikkarten nimmt immer weiter zu. Bei aktuellen Einsteigerkarten im Preissegment bis 150 Euro sind 2 GB als Speicher inzwischen Standard. Im Highend-Segment finden Sie 4 GB und mehr.

Nicht unerheblich bei der Auswahl der Grafikkarte ist aufgrund der Anzahl der Lüfter auch die Geräuschentwicklung. Bei unserer Schwesterzeitschrift GameStar ist dieses Kriterium seit Längerem fester Bestandteil der Tests. Ein wesentlicher Faktor für die Geräuschentwicklung ist die Bauform der Karte. Diese ist beim Referenzdesign der Hersteller normalerweise höher als beim Custom Design der Partner von AMD und Nvidia, die wesentlich stärker auf dieses Kriterium achten.

Dies verteuert zwar die Karte in der Regel ein wenig, dafür erhalten Sie allerdings deutlich leisere Lüfter und damit am Ende ebenfalls einen leiseren Rechner.

Aktuelle Grafikkarten besitzen heute zumeist mehrere Anschlüsse. Bei einigen Einsteiger-Grafikkarten gibt es noch immer den klassischen VGA-Anschluss. Bei diesem wird das Bildsignal immer noch analog übertragen, was deswegen zu einem viel schlechteren Ergebnis führt. Daher haben die meisten Karten ab dem mittleren Preissegment diesen Anschluss auch nicht mehr im Angebot.

Zum Standard gehören aktuell meistens sowohl ein DVI- als auch ein HDMI-Anschluss. Die Datenübertragung mit DVI erfolgt rein digital. Die Bilder erscheinen damit ohne Qualitätsverlust auf Ihrem Monitor.

Bei HDMI oder auch HDMI Mini können Ton und Bild mit einem Kabel übertragen werden. Dazu haben viele aktuelle Grafikkarten heute zusätzlich einen Soundchip integriert, der für die Tonausgabe sorgt. Dies funktioniert in der Regel ohne Probleme, liefert allerdings nicht die gleiche Klangqualität wie eine dezidierte Soundkarte. Durch die digitale Übertragung der Signale sind HDMI und DVI vom Ausgabeergebnis her vergleichbar. Verwenden Sie jedoch beispielsweise einen AV-Receiver an Ihrem Fernsehgerät, dann wäre das ein klarer Pluspunkt für einen HDMI-Anschluss.

Der Einbau der Grafikkarte gestaltet sich recht einfach, sofern genügend Platz in Ihrem Gehäuse ist und Sie die Abmessungen der neuen Hardware im Vorfeld berücksichtigt haben. Alle aktuellen Grafikkarten sind mit einem PCI-Express-Anschluss ausgestattet. Trennen Sie zum Einbau der Karte Ihren PC vom Strom, bauen Sie daraufhin das alte Modell aus und danach das neue ein. Schieben Sie die Karte senkrecht in den passenden Slot und drücken Sie leicht, bis die Karte einrastet.

Schließen Sie im nächsten Schritt die Stromversorgung an die Grafikkarte an, versorgen Sie Ihren Rechner dann wieder mit Strom und starten Sie ihn neu.

Bei den Grafikkarten liegt in der Regel eine CD oder DVD mit Treibern bei. Die Installationsprogramme bieten oftmals eine automatische Update-Funktion und suchen nach der aktuellsten Treiberversion im Internet. Falls dies bei Ihrem Gerät nicht der Fall ist, lohnt eine manuelle Suche auf der Website des Herstellers. Alternativ hierzu können Sie mithilfe von Programmen wie beispielsweise Drivebooster oder Slimdrivers automatisiert nach den aktuellen Treibern suchen lassen.

Betrachten Sie eine Grafikkarte nicht losgelöst von der CPU. Wenn Sie sich an das Aufrüsten Ihres Rechners machen, behalten Sie immer beide Komponenten im Blick und versuchen Sie, die beste Kombination für Ihr vorhandenes Budget zu finden.

Quelle User Eskin

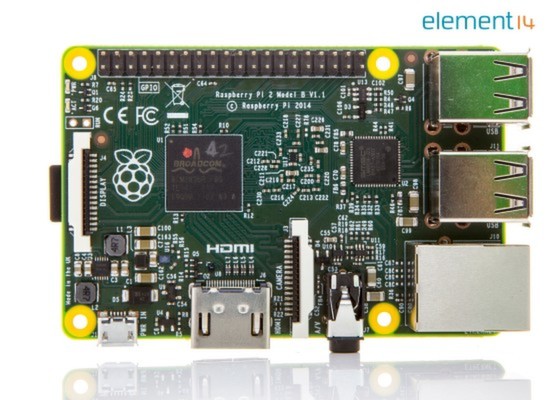

Raspberry Pi 2: Sechsfache Leistung dank Vierkern-Broadcom-Chip BCM2836

Linux ist bis dato das Raspberry-Betriebssystem. Dem brandaktuellen leistungsstarken Raspberry Pi 2 will Microsoft jetzt Windows 10 spendieren; gratis.

Der Raspberry Pi 2 mit neuem, leistungsstarken Vierkern-Broadcom-Chip BCM2836 wurde eben erst von Farnell und RS Components präsentiert.

Nun verrät Kevin Dallas, General Manager Windows IoT Group in seinem Blog, dass es „Windows 10 für Raspberry Pi kostenfrei für die Maker Community über das Windows Developer Program für IoT“ geben wird. Als Zeitpunkt nennt er „später in diesem Jahr“, also wahrscheinlich Ende 2015.

Microsoft sieht die Maker-Community als eine erstaunliche Informationsquelle für intelligente angeschlossene Geräte, die die Grundlage für die nächste Welle der Informationstechnik repräsentieren.

Letztes Jahr machte Microsoft einen wichtigen Schritt bei der Einbeziehung der Maker-Bewegung, indem das Software-Unternehmen das Windows Developer Program für IoT entwickelte und Windows für das Galileo-Board von Intel bereit stellte.

Jetzt hat Microsoft den Raspberry Pi ins Auge gefasst: via Windows Developer Program für IoT soll die Raspberry Pi Community Zugriff auf Microsofts Entwicklertools und Services erhalten.

Wie Microsoft den Raspberry Pi beurteilt

„Raspberry Pi entwickelte sich rasch zu einer der beliebtesten Plattformen der Community. Denn die vielseitig einsetzbaren, preiswerten Boards und Computer Modules ermöglichen Entwicklern, ihren Visionen Leben einzuhauchen. Raspberry Pi ist ein erstaunlich leistungsfähiges Gerät, das zahlreichen Menschen den Zugang zur Welt der Computer und Programmierung eröffnet.“

Sega ließ Sony abblitzen: Der größte Fehler der Firmengeschichte

Der ehemalige CEO von Sega, Tom Kalinske, bezeichnete die Ablehnung eines Sony-Angebots als einen der größten Fehler von Sega. Vor 20 Jahren waren Kalinske und Sony sich einig, gemeinsam eine Spielekonsole zu entwickeln: Der Sega-Vorstand lehnte jedoch ab. Dies bezeichnete Kalinske als größte Fehlentscheidung Segas und einen der Gründe für seinen Abtritt. Dennoch sei Sega eine starke Marke: Denn sie überlebte 20 Jahre voller Fehlentscheidungen – so Tom Kalinske in einem Interview mit GamesIndustry

Sega: Software statt Konsolen

Sega war in den 1990er Jahren zusammen mit Sony und Nintendo einer der führenden Konsolenhersteller. Nach dem mangelnden Erfolg der Dreamcast, zog sich Sega 2001 aus dem Konsolenmarkt zurück und konzentrierte sich auf Software und Arcade-Automaten. 2012 schloss Sega alle europäischen Außenstellen bis auf Großbritannien.

Sega ist für Spiele wie Total War, Sonic the Hedgehog und House of the Dead bekannt. Im Jahr 2013 übernahm Sega Relic Entertainment, das an der Entwicklung von Company of Heroes beteiligt war. Heute tritt Sega vor allem als Spiele-Publisher in Erscheinung, zuletzt etwa für Alien: Isolation.

WooW, ist das die neue Zukunft der Technik?

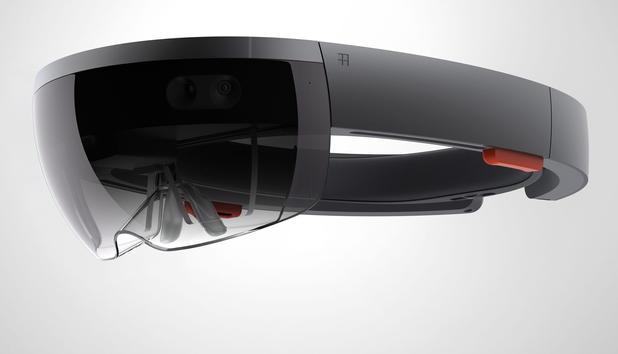

Für Staunen sorgte abseits aller Neuheiten von Windows 10 vor allem die überraschende Präsentation einer Entwicklung aus den Microsoft-Labors. Alex Kipman von Microsofts Kinect-Team demonstrierte an der Computer-Brille "HoloLens", wie virtuelle Welten in eine reale Umgebung eingeblendet werden können. So könne die Wirklichkeit zur Bühne etwa für ein Spiele-Level werden. Die virtuellen Gegenstände lassen sich mit Gesten und Sprache im Raum steuern.

Beeindruckende Ankündigung. So weit ist Microsoft freilich noch nicht.

Sollte "HoloLens" erfolgreich sein, dürfte die Entwicklung grundsätzlich den Weg verändern, wie Menschen mit Maschinen interagieren, wie es einst die Computermaus oder Apples iPhone getan haben, schätzt James McQuivey von Forrester. Die Marktforscher erwarten, dass bereits Ende 2016 Millionen Nutzer bereit wären, unabhängig von den Kosten eine solche Brille zu erwerben.

Cortana: Halo lässt grüßen

Eine prominente Rolle hat Microsoft auch Cortana zugewiesen. Microsoft-Manager Joe Belfiore demonstrierte, wie sich Cortana auch auf einem Personal-Computer mit Windows 10 als persönliche Assistentin einsetzen lässt. Cortana sei die bisher am stärksten personalisierte Sprachassistenz, sagte Belfiore. Microsoft konkurriert hier mit Diensten wie Google Now oder Siri von Apple. Der Name soll an die künstliche Intelligenz erinnern, die dem Videospiele-Maskottchen von Microsoft, dem Masterchief, in den Halo-Abenteuern zur Seite gestanden ist.

Cortana greift auf verschiedene Programme sowie die Suchmaschine Bing zu und kann zum Beispiel eine Wettervorhersage geben oder Tipps für die beste Route ins Büro. Künftig werde der Dienst im Browser Internet Explorer integriert sein. Über die selbstlernende Sprachsteuerung lasse sich zum Beispiel auch ein Platz in einem Restaurant reservieren, sagte Belfiore. Selbst das Menü könne Cortana dabei dem jeweiligen Geschmack entsprechend auswählen. "Wir ändern die Art, wie die Menschen den PC nutzen", sagte Belfiore.

221 Artikel (28 Seiten, 8 Artikel pro Seite)